GPT-4o 中的“o”代表“omni”——指的是 GPT-4o 的多模态。

在我们的深夜、太平洋时间的上午 10 点,OpenAI 召开春季发布会,推出了一款名为 GPT-4o 的“旗舰级”生成式人工智能模型,并将在未来几周内在公司面向开发者和消费者的产品中迭代推出。该模型将向免费客户开放,这意味着任何人都可以通过 ChatGPT 访问 OpenAI 最先进的技术。

GPT-4o 中的“o”代表“omni”,指的是 GPT-4o 的多模态。

会前,OpenAI 首席执行官(CEO)萨姆·奥特曼(Sam Altman)神秘兮兮地发了一条推文,给整个发布会奠定了基调:

“她”(Her)。

此刻应该没有人想得到,OpenAI 真的把 ChatGPT 变成了一个“女机器人”。

发布会全程回顾:她来了

发布会的第一个“她”——OpenAI 首席技术官(CTO)Muri Murati 亮相直播间,迅速带来了关于 GPT-4o 以及 ChatGPT 最新特性的一系列介绍。

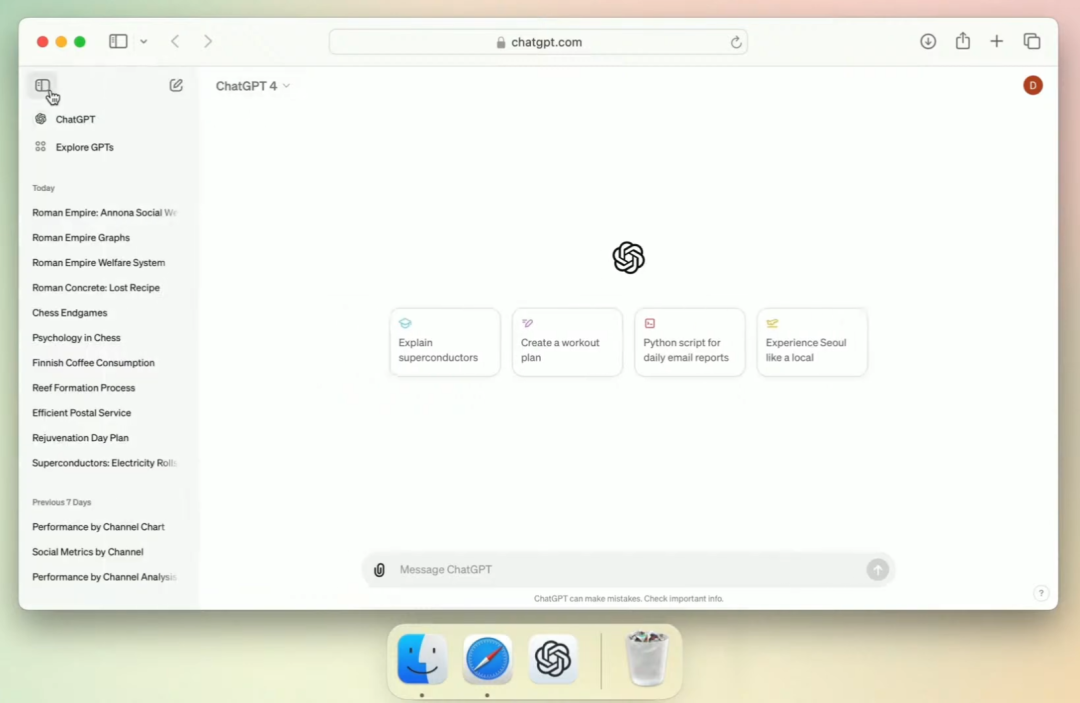

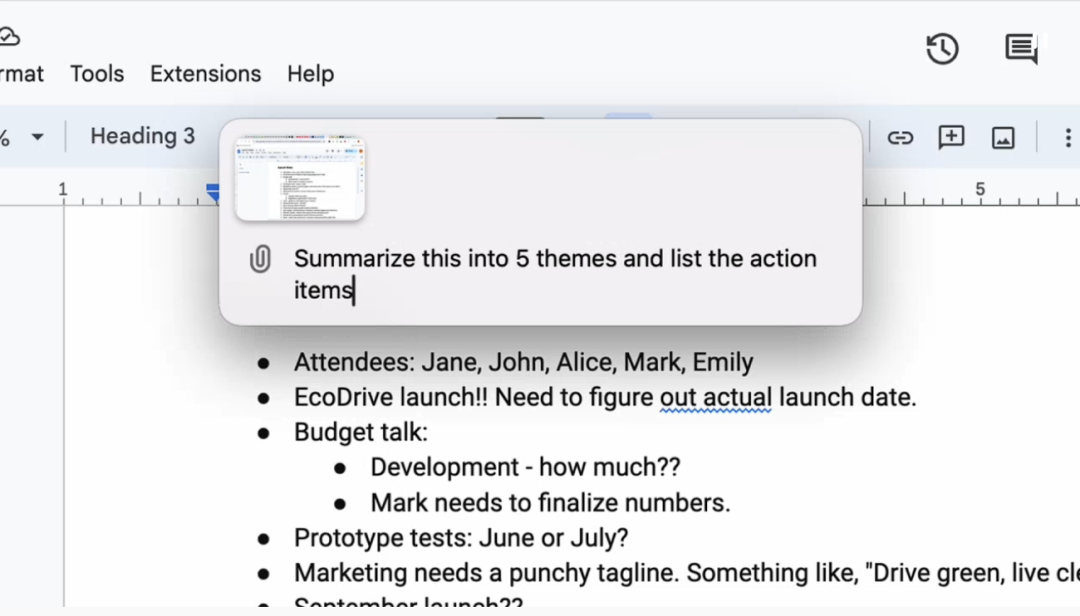

ChatGPT 桌面版及用户界面优化

会议首先介绍了 ChatGPT 桌面版的发布,旨在通过简化用户界面,提升产品的可用性和访问便捷性。新设计强调简洁直观,确保用户能自然流畅地与 ChatGPT 互动,无论何时何地。

由于重头戏是 GPT-4o,这里就不多介绍桌面版 ChatGPT 有多酷了,我们等到后面第三部分讲 OpenAI 官方博客的时候再进一步深入。

GPT-4o 模型发布

Muri Murati 紧接着就把重点转向了 GPT-4o 模型的发布,这是对现有技术的一次重大飞跃,首次将 GPT-4 级别的智能普及到所有用户,包括免费用户。GPT-4o 不仅在文本处理方面表现出色,还在图像和音频处理能力上实现了显著增强,标志着人机交互进入了一个更为自然和便捷的新时代。

Murati 接着讲到,OpenAI 的核心使命之一是普及尖端 AI 工具,通过减少使用障碍,如无需注册即可使用 ChatGPT,以及推出桌面应用程序,让技术触手可及。这些努力是为了直观展现技术潜力,促进广泛的认知融合。GPT-4o 的发布标志着人机交互方式的革新,它能够处理对话的微妙细节,如自然语言理解、环境噪音过滤及多声部对话,这些都是传统上对 AI 模型的巨大挑战。通过内置转录、智能分析和文本转语音等功能,GPT-4o 大大降低了交互延迟,提升了沉浸式体验。

以往仅对付费用户开放的一些高级功能,现在得益于 GPT-4o 的效率提升,将免费提供给所有用户。这意味着更多的用户可以享受定制化体验、视觉上传功能、记忆和浏览功能,以及高级数据分析服务。

Murati 宣布,ChatGPT 的用户已经达到了 1 亿。

ChatGPT 新增的视觉支持功能允许用户上传图片和文档,记忆功能确保对话连贯,浏览功能实现实时信息搜索,数据分析则处理图表和数据信息,提供即时答案,这些都极大增强了 ChatGPT 的实用性。此外,GPT 4.0 在 50 种语言上的表现得到了显著的速度和质量提升,这对于全球用户来说是一个重要的进步,确保了服务的广泛普及。

场面话结束了,接下来将是见证“魔法”的时刻。

会前,Altman 曾经这么说过:就像魔法一样。

科幻片上映——GPT-4o 超强现场演示

Murati 邀请了两位 OpenAI 的研究主管上台,他们是 Mark Chen(图左,推特:@markchen90)和 Barrett Zoph(图右推特:@barret_zoph)。

未来教学人机交互史的时候,这两个人的名字可能会成为考试的一道问题。

无延迟语音实时对话,还能打断发言

Muri Murati 紧接着就把重点转向了 GPT-4o 模型的发布,这是对现有技术的一次重大飞跃,首次将 GPT-4 级别的智能普及到所有用户,包括免费用户。GPT-4o 不仅在文本处理方面表现出色,还在图像和音频处理能力上实现了显著增强,标志着人机交互进入了一个更为自然和便捷的新时代。

本次展示聚焦于 ChatGPT 应用的实时对话语音功能,通过现场演示,展示了用户与 AI 之间流畅无阻的交互体验。Mark Chen 通过手机上的应用程序,激活了 GPT-4o 的音频功能,与 AI 进行了实时对话,并体验了其即时响应与情绪感知能力。

Mark 告诉聊天机器人,他对这次演示很紧张,请 ChatGPT 给他一些建议,帮助他冷静下来。然后,Mark 对着自己的手机大喘气模拟了一下深呼吸,ChatGPT 调侃了回去:“Mark,你又不是吸尘器!”

Mark 特别指出了新功能与旧语音模式的主要区别:用户现在可以直接打断模型,无需等待模型完成发言即可插话,大大提高了对话的自然流畅度。此外,新模型消除了延迟现象,反应迅速,不再有尴尬的等待时间。更重要的是,它能够感知用户的情绪状态,根据用户的语气和节奏调整交流方式,展现出更人性化的交互体验。

随后,ChatGPT 被要求用各式各样的腔调来讲述一个故事,在这段演示里,Mark 和 Barret 反复地打断 ChatGPT,并重新要求她换个腔调讲故事。她能够根据用户要求调整语音的语调和情感色彩,从平静叙述到充满戏剧性的讲述,再到以机器人的声线讲述故事,甚至通过歌唱来结束故事,极大地丰富了交流的互动性和趣味性:

GPT-4o 加持的 ChatGPT 正在变得越来越“情绪化”。情绪感知是此次更新的一大亮点,ChatGPT 不仅能够识别用户的情绪,还能在对话中适时提出建议。这种能力让 AI 能够更贴近用户需求,提供更具针对性的帮助和支持。这与 Inflection.ai 开发的人工智能应用 Pi 非常相似,但 Inflection.ai 之前就已经被微软收购了(微软又和 OpenAI 有着难舍难分的关系)。

视觉 + 推理

GPT-4o 还改进了 ChatGPT 的视觉能力。ChatGPT 现在能“看见”事物并进行推理。通过手机摄像头,她看到了一道写在纸上的数学题,并帮助两位演示者解题:

通过一个线性方程的实例(3x + 1 = 4),对话深入到具体的数学问题解决策略中。

然后,Barret 在纸上又写了“我爱 ChatGPT”(I love ChatGPT)的字样,她的反应也是相当精彩:

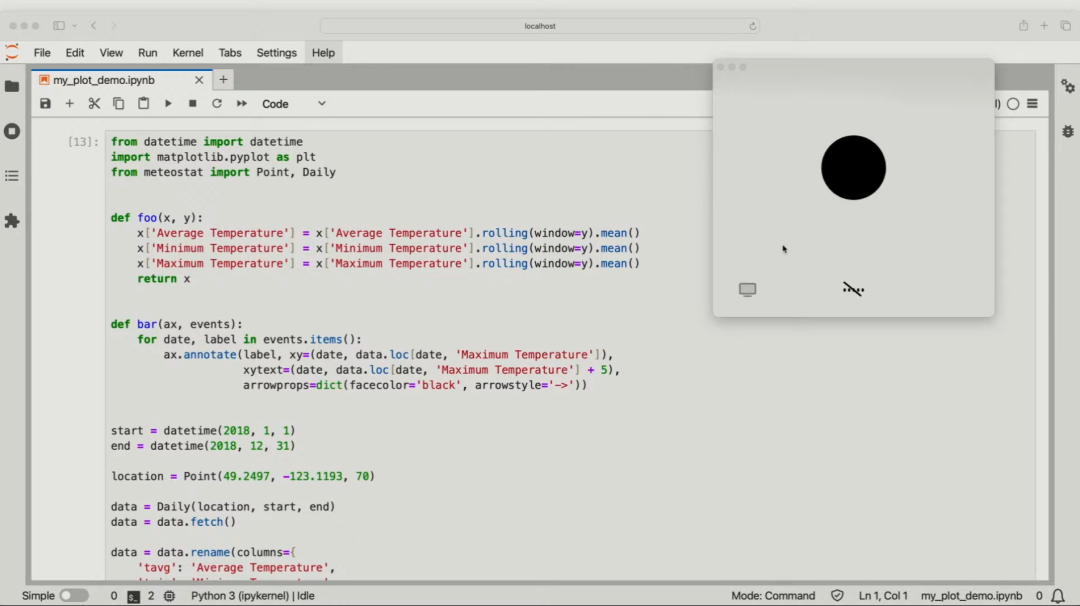

接下来,她又被要求解释一些计算机代码,顺带展示了最新的 ChatGPT 客户端:

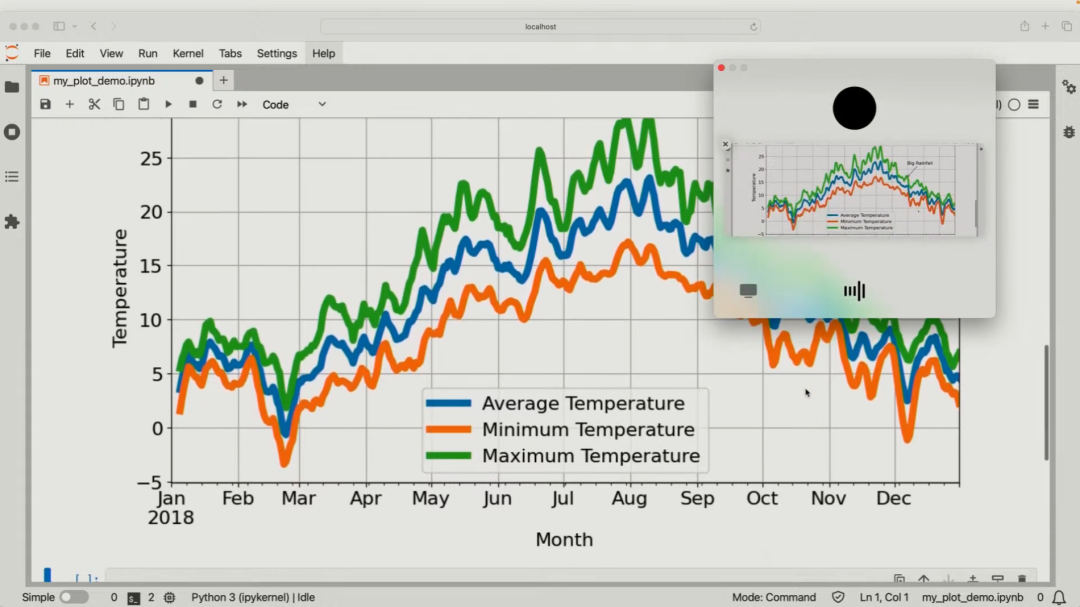

Barret 分享的代码旨在处理特定地点及时间段的天气数据,通过移动平均法平滑温度数据,并可视化全年气温变化。在代码执行后,通过启用 ChatGPT 的视觉功能,双方共享了图表内容。

图表展示了 2018 年全年温度变化,特别指出了 9 月末的大雨事件,以及 7 月和 8 月的最高温区间(约 25 到 40 摄氏度)。这一环节不仅验证了代码的正确执行,也突显了 ChatGPT 处理数据、生成图表和分析结果的能力。

能言善辩、感知情绪

Mark 之后演示了 ChatGPT 的即时翻译能力:每当他说英语的时候,ChatGPT 要翻译成意大利语并告诉旁边的 Murati;而 Murati 用意大利语回应时,ChatGPT 又得翻译成英语给 Mark 做解释:

通过英语与意大利语的互译,展示了跨语言交流的便捷性,强化了其作为一个沟通桥梁的角色。

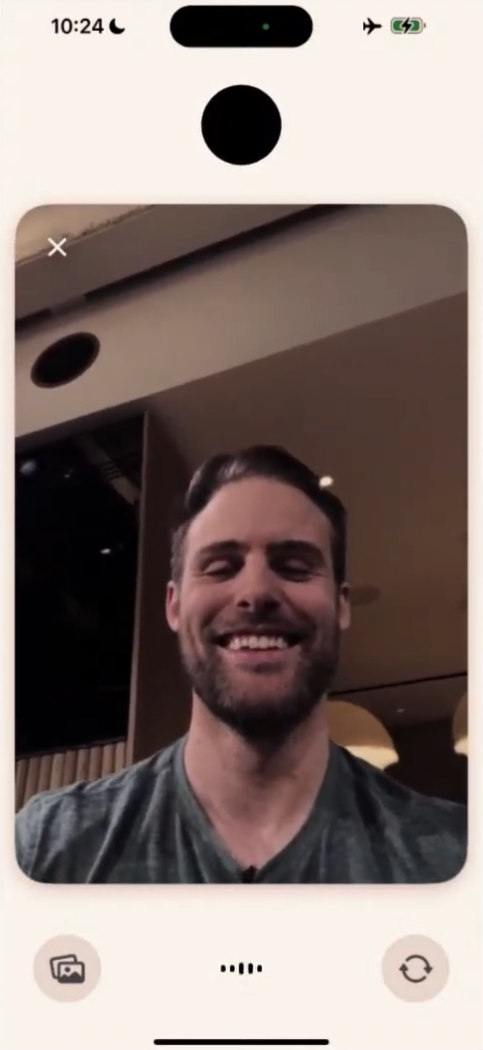

在另一个互动环节中,通过一张自拍照,ChatGPT 被要求根据 Barret 的面部表情推断情绪,成功识别出他愉快和兴奋的情绪状态。

发布会宣告尾声,三位演示者表示 GPT-4o 未来即将向更广泛的用户群体开放新功能,并对 OpenAI 团队和 NVIDIA 团队的支持表达了感谢。

会后“众生相”:像推土机一样摧毁行业!

AI 春晚的影响力不可小觑,整个圈内都陷入了激动的状态,只可怜谷歌明天的 I/O 大会了。在众多反应里,几位 AI 圈的名人也先后出来展示了自己的看法:

Andrej Karpathy 曾担任特斯拉的人工智能和自动驾驶视觉总监,负责领导 Autopilot 团队,这是从 2017 年开始的,当时埃隆·马斯克从 OpenAI 将他挖角至特斯拉。在此之前,他还是 OpenAI 的创始成员之一,拥有在斯坦福大学的学术背景,并且是“AI 教母”李飞飞的学生。

这位大神第一时间分享了自己的 reaction:

OpenAI 正在发布一个集成了文本-音频-视觉的模型,该模型在一个单一的神经网络中处理全部三种模态。这样一来,只要你要求,它就能够作为特殊情况下的一个补充功能,实现实时语音翻译。

引得马斯克在底下评价:“这是个更好的表达方式”。

英伟达研究科学家 Jim Fan 是 AI 圈的“网红”,他一向走在 X 的资讯前沿,这次同样也是发表了相当深度的解析:

现在你的动态可能满是诸如“不可思议的突破、《HER》、本次发布会你错过的十大特性、王者归来”这样的字眼。不妨静下心来,跟着我的节奏一步步剖析。高质量的数据至少可以从两个来源获得:1. 来自 YouTube、播客、电视剧、电影等自然发生的对话。Whisper 可以被训练来识别对话中的发言者轮换或分离重叠的语音以进行自动标注。2. 合成数据。使用最强大的模型运行慢速的三阶段管道:speech1->text1(ASR),text1->text2(LLM),text2->speech2(TTS)。中间的 LLM可以决定何时停止,也可以模拟被打断后如何接话。它可以输出未被口头化的额外“思维轨迹”(也就是它内心的想法),以帮助生成更好的回复。然后 GPT-4o 直接从 speech1->speech2 进行蒸馏,基于三阶段数据的可选辅助损失函数。蒸馏后,这些行为现在内置于模型中,不再输出中间文本。 系统方面,如果每个视频帧都解压缩为 RGB 图像,则延迟将无法满足实时阈值。OpenAI 可能已经开发了自己的神经优先、实时视频编解码器,将运动增量作为 token 进行传输。通信协议和神经网络推理必须共同优化。例如,可以在边缘设备上运行一个小型、高能效的神经网络,如果视频有趣,它就会决定传输更多 token,反之则更少。 我没想到 GPT-4o 会更接近传闻中的 GPT-5,即“Arrakis”模型,它能实现多模态输入和输出。实际上,它可能是 GPT-5 的一个早期检查点,尚未完成训练。 品牌命名也透露出某种不安全感。在 Google I/O 之前,OpenAI 宁可超预期地推出 GPT-4.5,也不想因 GPT-5 的高期待而栽跟头。这算是一种争取时间的明智之举。 值得注意的是,这个语音助手变得更加活泼,甚至有点轻佻。GPT-4o 正在努力(也许有点太努力了)让自己听起来像《HER》。OpenAI 在蚕食 Character AI 的市场份额,两者在形态上几乎完全重合,并拥有庞大的分销渠道。这是向更具情感、个性更强的人工智能发展的一个转折点,而 OpenAI 过去似乎一直在积极压制这一点。 谁先赢得苹果,谁就将大获全胜。我认为与 iOS 的集成有三个层次:1. 放弃 Siri。OpenAI 为 iOS 精简出一个纯粹的设备端 GPT-4o,可选择付费升级以使用云服务。2. 将摄像头或屏幕串流到模型中的本地功能。芯片级支持神经音频/视频编解码器。3. 深度融入 iOS 行动接口和智能家居生态。Siri Shortcuts 曾遭冷遇,但这次,它将以十亿用户级别的 AI 助手身份华丽回归。智能手机的 FSD,具有特斯拉级别的数据飞轮。

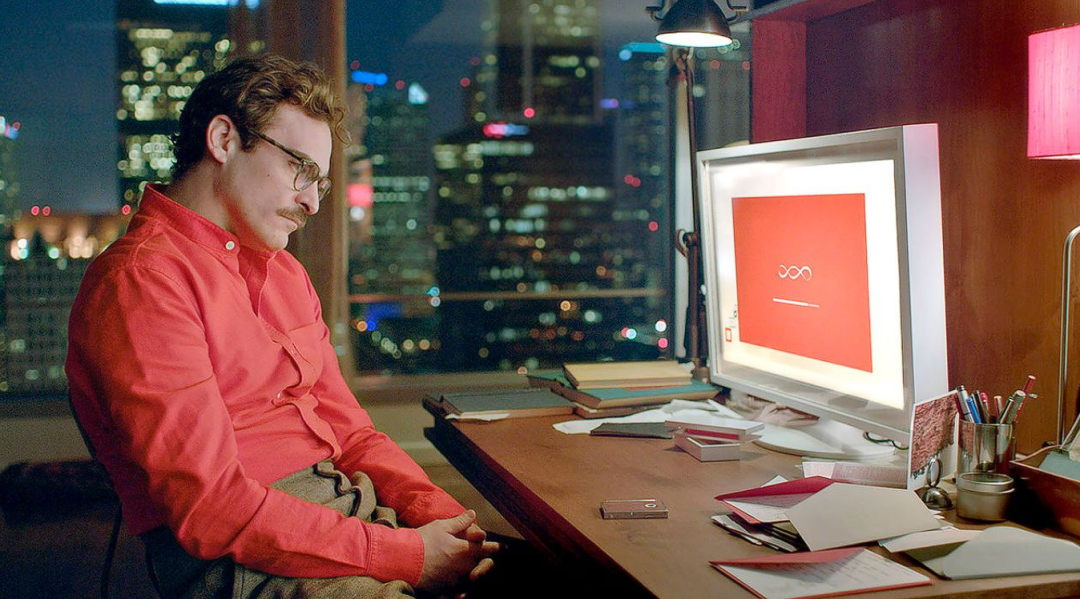

Jim Fan 文中提到的 HER 正是 Sam Altman 在发布会前暗示的那部电影。这部由 Spike Jonze 执导的电影《Her》是一部科幻爱情片,设定在未来不远的洛杉矶。故事围绕一位名叫西奥多·托姆布雷(Theodore Twombly)的男子展开,他是一名信件代笔人,专门为那些不善于表达情感的人撰写感人信件。西奥多生活在一个高度发达的科技世界中,人类与技术的互动变得日益亲密和复杂。

而本次演示的 ChatGPT,其声音几乎和电影里的“Her”一模一样——电影的女主角正是一款先进的人工智能操作系统 OS1,这个系统具有高度发达的人格化特征,并自称萨曼莎(Samantha)。OpenAI 用非常浪漫的方式完成了一次致敬。

如果你对这场直播还没看够,那么 OpenAI 联合创始人 Greg Brockman 肯定能满足你的需求。Greg 直接在 X 上追加了五分钟的演示视频,让 ChatGPT 即兴创作了一首歌曲,歌词中巧妙融入了房间的装潢风格、在场人物的穿着特色以及其间发生的趣事:

进一步解析:原来你就是 gpt2?

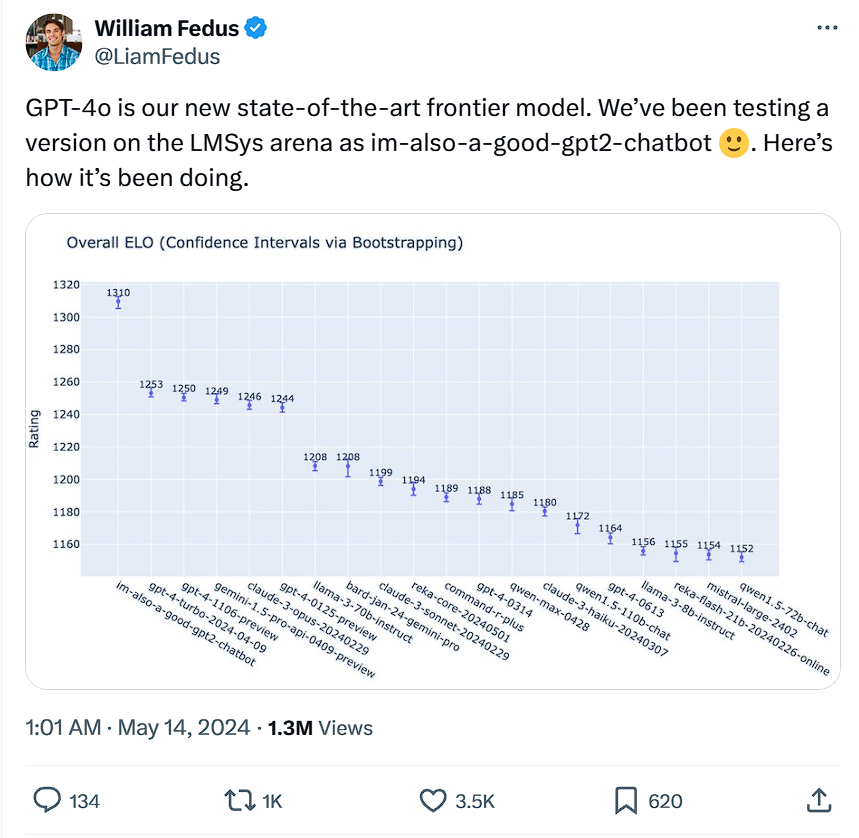

发布会刚结束,OpenAI 技术人员 William Fedus 便在 X 上发布了一项重磅消息。此人师承“AI 三巨头”之一的 Yoshua Bengio,还曾在 Google Brain 镀过金。

Fedus 表示,前段时间在“AI 竞技场” LMSys 打遍天下无敌手的“im-also-a-good-gpt2-chatbot”,其实就是 GPT-4o!并且,Fedus 还公布了一则更详细的数据:

Fedus 说,ELO 评分最终可能会受到提示难度的限制(即,在诸如“最近怎么样”这样的提示上无法达到任意高的胜率)。且他们发现,在更难的提示集上——尤其是编程任务中——这种差距甚至更大:GPT-4o 相比 OpenAI 之前最好的模型,ELO 评分高出 100 多分。差距大到令人绝望。

下一环节,让我们深入本次发布的详细内容,看看 ChatGPT 和 GPT-4o 未来的发布计划都有哪些。

详细发布内容

OpenAI 宣称,GPT-4o 在理解和探讨用户分享的图片方面已超越所有现存模型。举例来说,你只需拍摄一份外语菜单,GPT-4o 就能帮你翻译内容、了解菜品背后的文化故事并提供建议。未来,技术升级将实现更加流畅、实时的语音交互,以及通过实时视频与 ChatGPT 对话的能力。比如,我们可向 ChatGPT 展示正在进行的体育赛事,让它讲解规则。接下来数周内,OpenAI 将启动带有这些新功能的语音模式 Alpha 测试,Plus 用户将首批体验,随后逐步扩大覆盖范围。

目前,ChatGPT 已支持超过 50 种语言,覆盖注册、登录、用户设定等多个环节。GPT-4o 正逐步向 ChatGPT Plus 和团队用户开放,企业版也将很快面世。同时,免费用户今日起也可体验,但设有使用配额。Plus 用户的消息发送上限将是免费用户的 5 倍,团队和企业用户则享有更高额度。

借助 GPT-4o,免费用户将能体验:

- GPT-4 级别的智能互动

- 结合模型与网络的回复

- 数据分析与图表制作

- 图片话题讨论

- 文件上传以辅助总结、创作或分析

- 探索并使用 GPT 及 GPT 商店

- 利用记忆功能构建更佳体验

根据使用量和需求,免费用户使用 GPT-4o 的消息数量将有限制。一旦达到上限,ChatGPT 将自动切换至 GPT-3.5,确保对话延续。

无论是免费还是付费用户,OpenAI 都推出了全新的 macOS ChatGPT 桌面应用,无缝融入日常电脑操作。只需要简单快捷键(Option + Space)即可随时提问 ChatGPT,还能直接在应用内截图并讨论。从今天开始,用户就可以直接通过电脑与 ChatGPT 进行语音交流,初期会以 Voice Mode 形式呈现,未来将集成 GPT-4o 的音频视频新功能。无论是公司创意头脑风暴、面试准备还是话题探讨,只需点击桌面应用右下角的耳机图标即可开始语音对话。

参数 pk 环节

GPT-4o 能在 232 毫秒内对音频输入做出反应,平均反应时间为 320 毫秒,这与人类在对话中的反应时间相近。

未来,就变成了我们讲话比 ChatGPT 慢半拍了……

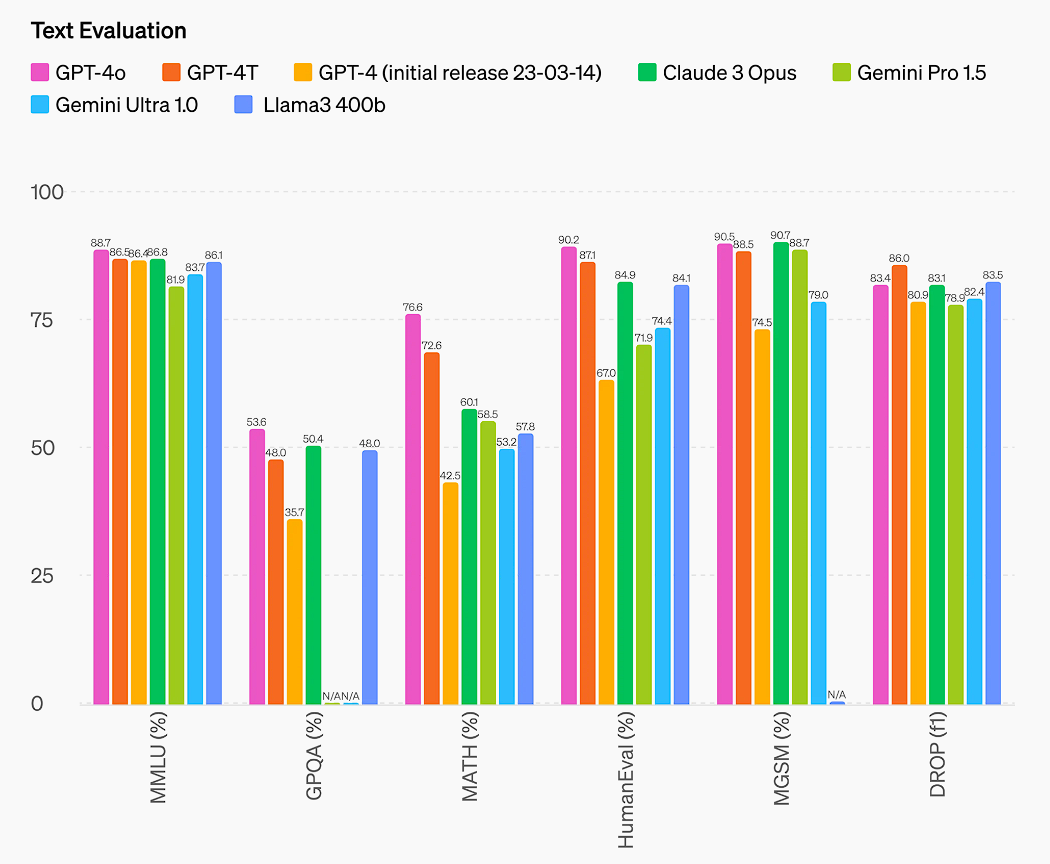

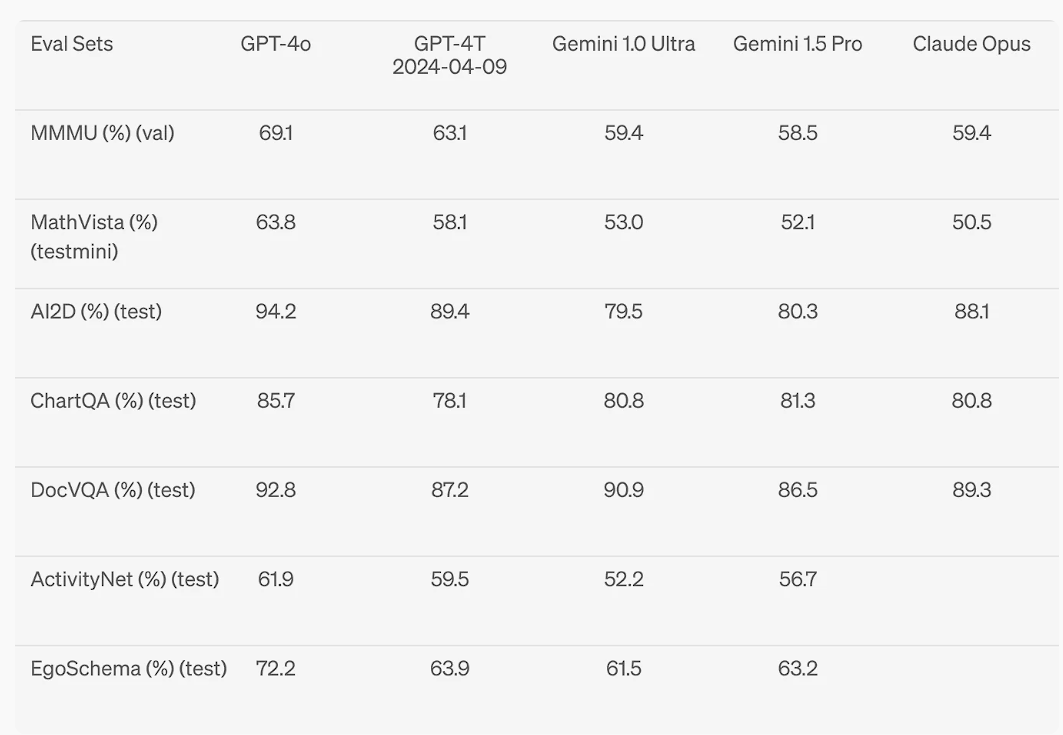

GPT-4o 在英语和代码文本方面的性能与 GPT-4 Turbo 相当,在非英语语言文本方面也有显著提高,同时在应用程序接口(API)方面速度更快,价格便宜 50%。与现有模型相比,GPT-4o 在视觉和音频理解方面尤其出色。

本次升级是多模态方面的飞跃,我们会发现 GPT-4o 的文本、推理和编码水平仍和 GPT-4 Turbo 相当。

真正“遥遥领先”的,显然是多语种交互、音频对话、视觉等方面。

最后总结,从今天开始,GPT-4o 强大的文本理解与图像处理能力会逐步融入 ChatGPT。不仅限于免费用户群体,Plus 用户更能享受到高达标准用户 5 倍的消息发送限额。此外,一个整合了 GPT-4o 的语音模式 Alpha 版本,预计在未来数周内登陆 ChatGPT Plus。

对于开发者而言,GPT-4o 现已通过 API 开放,成为可调用的文本和视觉识别模型。与 GPT-4 Turbo 相比,它在速度上快出两倍,成本减半,且请求频率上限提升至原来的五倍。

最后的最后,以一个令人尴尬的推文结尾。

试试,新一代AI效率神器 @ 海鲸AI