随着人工智能技术的飞速发展,越来越多的企业和机构开始意识到知识库的重要性。

知识库不仅能够集中管理大量的信息和数据,还能通过智能检索和推理功能,为用户提供准确、高效的知识服务。

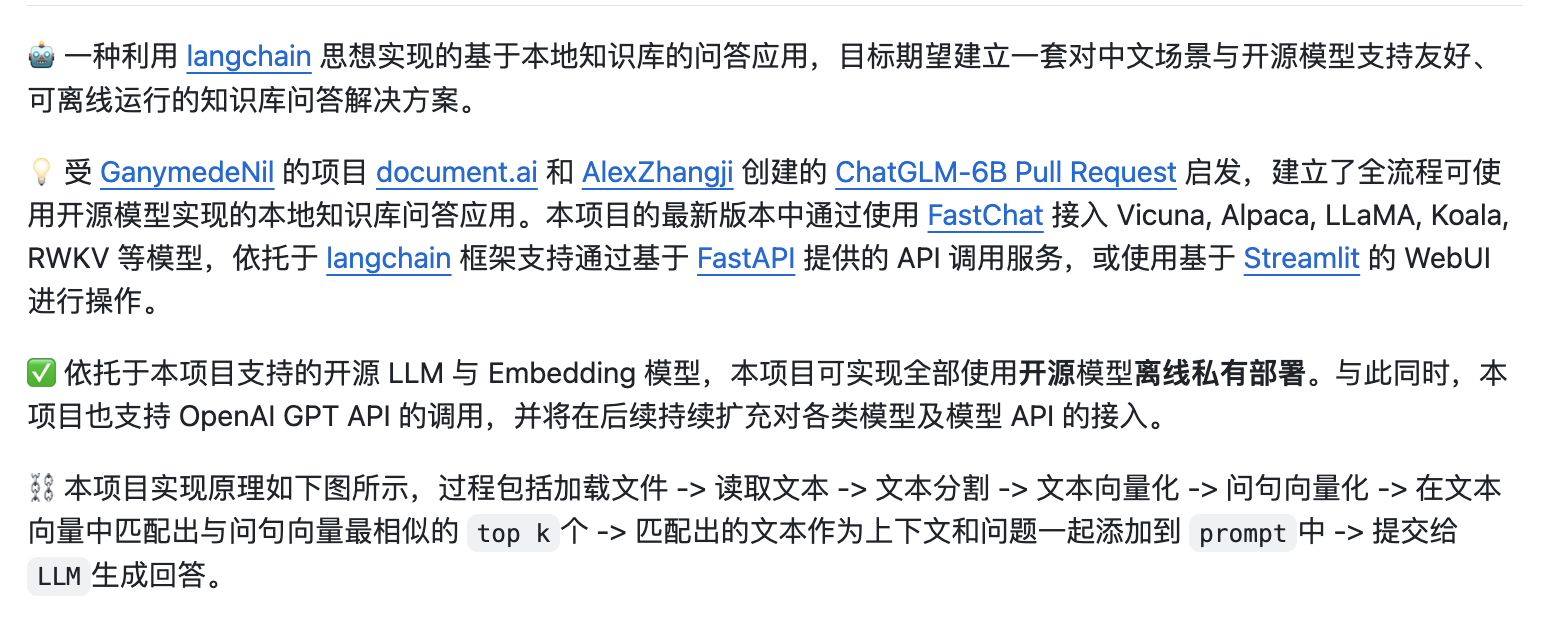

LangChain与ChatGLM作为当前领先的AI技术,为部署本地私有化知识库提供了强大的支持。

LangChain与ChatGLM简介

LangChain是一个功能强大的自然语言处理框架,集成了多种先进的NLP技术,包括文本生成、语义理解、情感分析等。通过LangChain,我们可以轻松地构建出功能强大的聊天机器人、智能问答系统等。

ChatGLM是基于GLM(生成语言模型)的自然语言处理模型,具备强大的文本生成能力和语义理解能力,可以为用户提供高质量的对话体验。

私有化知识库的优势

私有化知识库是指将知识库部署在企业或机构的内部网络中,以实现数据的集中管理和安全控制。与公有云知识库相比,私有化知识库具有以下优势:

- 数据安全:私有化部署可以确保数据的安全性和隐私性,避免数据泄露和非法访问。

- 自主可控:私有化知识库允许企业或机构自主管理和控制数据,确保数据的准确性和完整性。

- 灵活定制:私有化部署可以根据企业或机构的实际需求进行定制,满足特定的业务需求。

基于LangChain与ChatGLM的私有化知识库部署方案

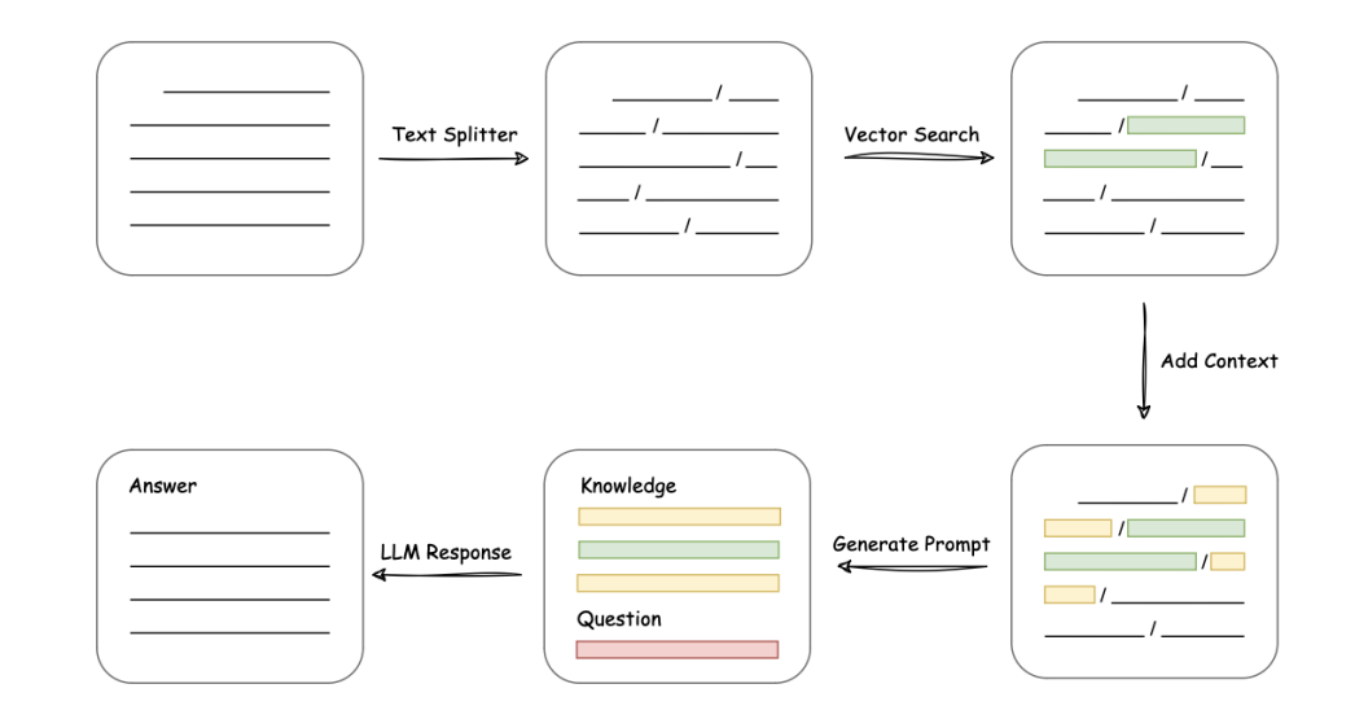

基于LangChain与ChatGLM的私有化知识库部署主要包括以下几个步骤:

- 需求分析:明确企业或机构的知识库需求,包括数据类型、数据存储方式、用户访问方式等。

- 环境搭建:搭建适合LangChain与ChatGLM运行的环境,包括服务器、存储设备等。

- 模型训练与部署:利用LangChain与ChatGLM进行模型训练,将训练好的模型部署到私有化知识库中。

- 数据导入与整理:将企业或机构的数据导入到知识库中,并进行整理和优化,以提高检索和推理的准确性。

- 系统测试与优化:对部署好的私有化知识库进行系统测试,根据测试结果进行优化和调整。

通过容器化快捷部署:

docker run -d --gpus all -p 80:8501 registry.cn-beijing.aliyuncs.com/chatchat/chatchat:0.2.3基于LangChain与ChatGLM的私有化知识库部署方案为企业和机构提供了一个高效、安全、可控的知识管理解决方案。企业可以根据自身的服务器、硬件资源等相关条件,选择相应的LLM模型。

未来,随着AI技术的不断发展,我们有理由相信,私有化知识库将在更多领域得到应用和推广,为企业和机构带来更大的价值。与早期的知识库开发相比,AI在语义、语境搜索、上下文联想、召回率、相关性、准确度等各方面表现出色,尤其是在垂直领域的知识管理中,AI检索使得回答更加精准(前提是提示词给得恰如其分),效果更受用户青睐!

这样,一个本地私有化知识库应用就完成了搭建。当然,也需要持续关注应用的运行情况,并根据用户反馈和市场需求进行迭代和更新,这包括优化用户体验、增加新功能等。

思考与延伸

AI在各个领域中的应用越来越广泛,各种大模型相继面世,特别是在大数据、深度学习技术以及新质生产力政策的推动下,通过投入研发,相比于依赖外部模型,打造本地私有化应用可以更好地掌控数据的安全性和可控性。

企业可以自主决定数据的采集、存储和使用方式,确保数据的安全性、隐私性,避免因数据泄露或滥用带来的风险。对于通过AI技术推动业务发展和创新的企业和团队来说,这是一个值得投入和尝试的方向。

这不仅有助于实现定制化需求、掌握核心技术、推动创新与发展,还能够培养人才团队和增强数据的安全性与可控性!

海鲸AI,大模型落地应用首选服务商

定位:开箱即用的大模型落地应用平台

承诺:先做场景POC验证,看到效果再签署服务协议。零风险落地应用大模型,已交付20+中大型企业。

试试,新一代AI效率神器 @ 海鲸AI